これまで

3DCGモデルに動きを与えるモーションデータの作成に関して、

ケースバイケースで、最善の策を調べてきました。

<これまで紹介してきた例>

既存のモーションデータを改変してオリジナルモーションを作成する方法↓

mixamoのモーションデータを改変する方法↓

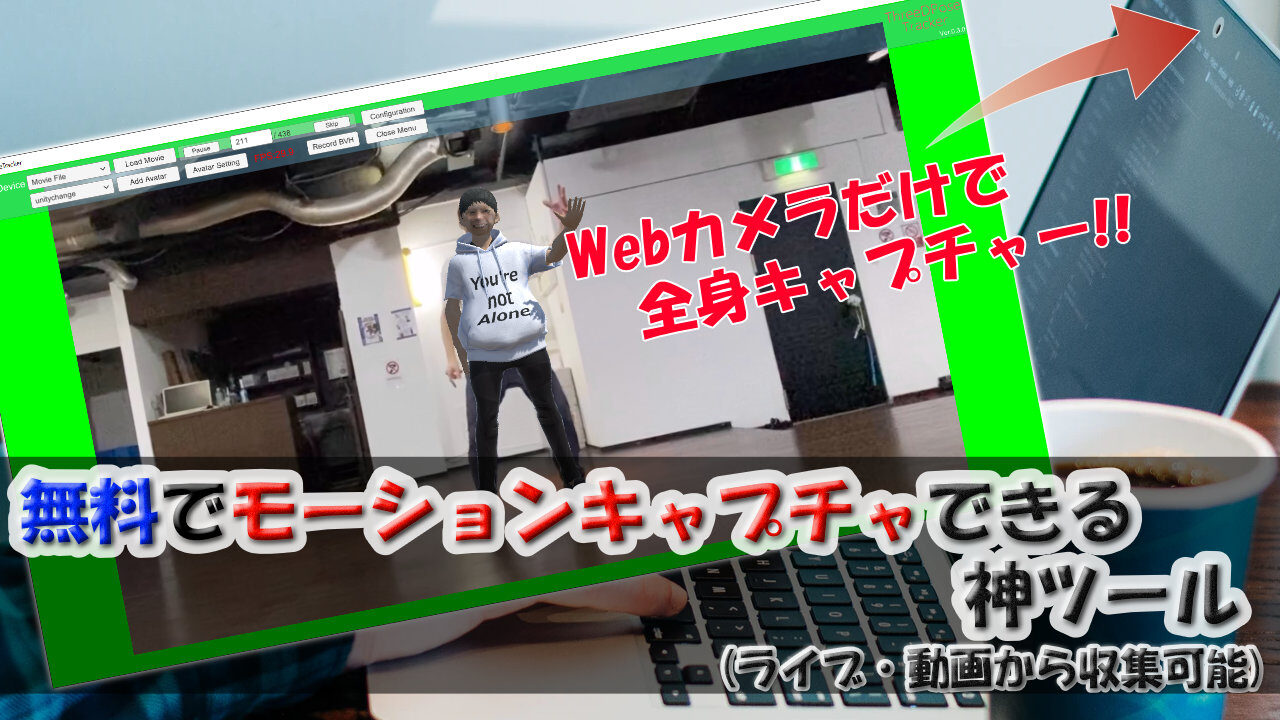

今回紹介するツールは、モーションキャプチャできるものです!

「あぁ、手足にセンサーとなるデバイスをつけるヤツね…高価なんだよな…」

そう思って、

Ocullus Quest(VRデバイス)やリープモーション(手指センサー)

の購入を後にした方、

朗報です。

このツールは、

パソコンとWebカメラさえあれば、

モーションキャプチャできます(しかも全身)!!

優れたAIが搭載されたことによって、

身体のパーツパーツの位置や回転を高速で解析できるからだそうです。

そのツール名は「ThreeDPoseTracker」

というもので、無料で公開されています!

詳細はQiitaで説明されています↓

https://qiita.com/yukihiko_a/items/43d09db5628334789fab

これを使えば、

ライブ配信などでモデルを動かすのに使える他、

キャプチャしたモーションをデータとして作成・保存できるので、

Vtuberに限らず、CGをクリエイトする方にとって、助けになるツールだと思います。

実際、私はそのツールを用いて

3Dモデルを踊らせ、人生初のCG動画を作成しました^^;

※自分が踊った動画をモーションキャプチャし、3Dモデルのアニメーションに組み込みました。

プルプル震えてたりしますが、完成度は求めないでください^^;

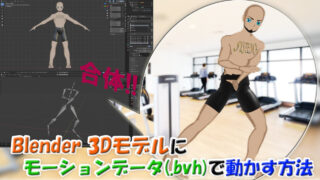

Blenderにモーションデータ(bvh)をインポートし、修正すれば綺麗に仕上げていくことができます。

bvhモーションデータをBlenderにモデルに適用する方法はこちら↓

本ソフトの詳しい使い方は、

上記のQuiitaサイトに書かれているので、導入方法だけ。

<導入方法>

qiitaアドレスより、ファイルをダウンロードしたら、フォルダ内の「ThreeDPoseTracker.exe」をクリックで起動するだけです。

リソースをWebカメラにすると、その瞬間身体の動きに合わせてモデルが動きます。

リリースを動画ファイルにすると、動画に移る人間を検出してモデルが動きます。

さらに、基本グリーンバックなので、

このウィンドウ内で自分の動きに合わせて動くモデルを

動画に合成すれば、Vtuber配信ができます^^

どうやって合成するの?とわからない方は、

下の記事をご覧ください。

(”3tene”というソフトでグリーンバックのモデルが動く映像を使い、OBS Studioで、他の動画や背景画像の上に重ねます)

ちなみに・・・上の動画のアバターはクオリティは低すぎますが、

もっと写真に近いリアルガチアバターを

コストをかけずに作る方法がわかりました!完全解説してるのは本ブログだけ!↓

効率よくソフトの使い方を学びましょう~^^